1. 引言:数据时代的挑战与机遇

在信息化迅速发展的时代,大数据已成为企业不可或缺的资源。企业无论大小都在努力从数据洪流中寻找价值,大数据开发者因此成为了连接技术与业务需求的关键人物。他们利用先进的技术来解决从客户行为分析到产品优化的各种问题。

随着数据量呈指数级增长,企业面临着数据存储、处理和分析的巨大挑战。同时,这也带来了前所未有的机遇:

- 获得更精准的市场洞察

- 做出更明智的决策

- 开发出更符合用户需求的产品和服务

大数据开发者在这个过程中扮演着至关重要的角色。他们不仅需要掌握复杂的技术栈,还要具备跨领域合作的能力,将技术创新与业务目标紧密结合。本文将深入探讨大数据开发者的核心技能、职责,以及他们如何影响现代商业和社会的各个方面。

2. 大数据开发者角色解析

2.1 职责与期望

**大数据开发者的核心职责是设计、构建和维护大规模的数据处理系统。**他们确保数据的质量和效率,支持复杂的数据分析和数据驱动的决策制定。此外,他们还需要与数据科学家和业务分析师紧密合作,提供技术支持,使数据科学项目能够顺利进行。

具体来说,大数据开发者的职责包括:

- 设计和实现高效的数据采集、存储和处理架构

- 开发和优化数据管道,确保数据的及时性和准确性

- 构建和维护数据仓库,支持复杂的查询和分析需求

- 开发数据可视化工具,帮助非技术人员理解和利用数据

- 确保数据安全和隐私保护,遵守相关法规和标准

- 持续优化系统性能,提高数据处理的效率和可扩展性

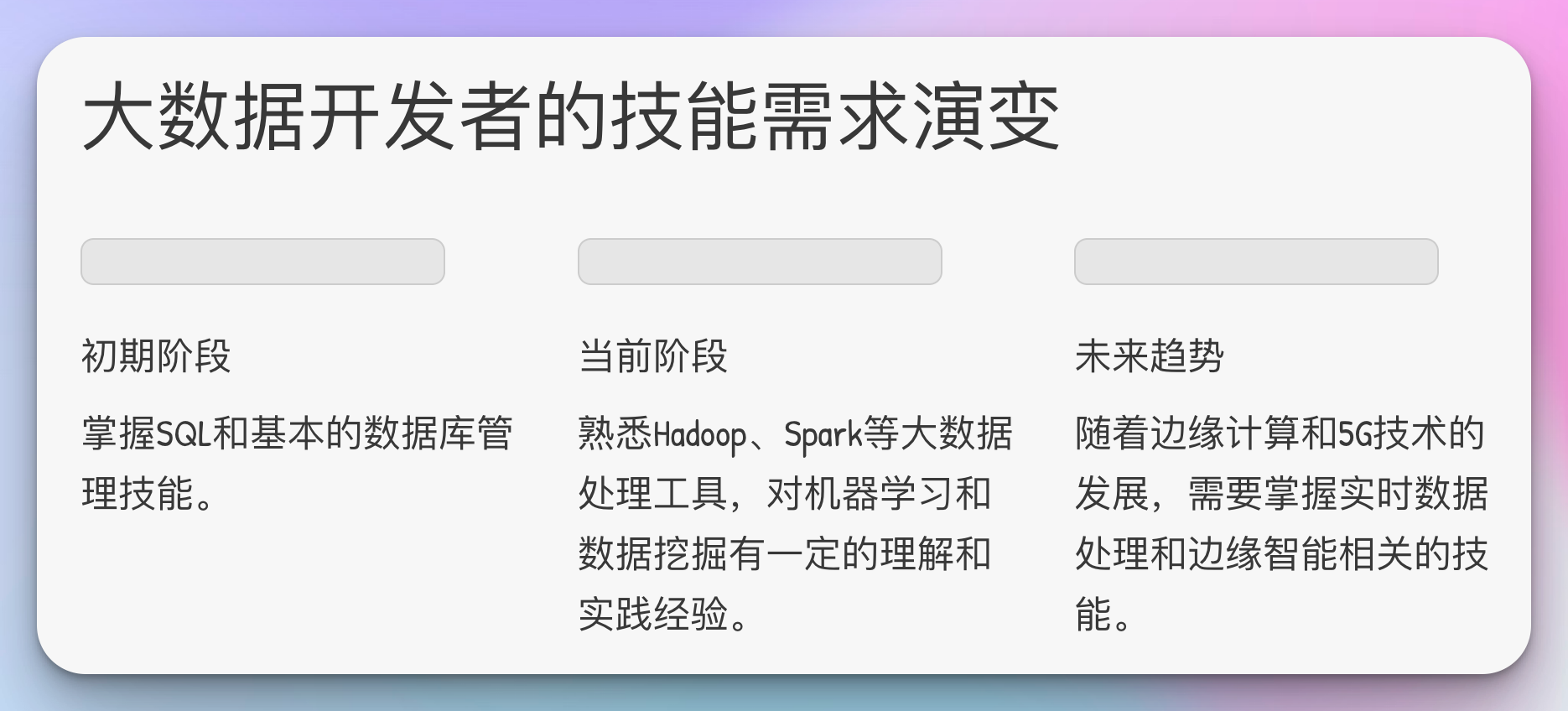

2.2 技能需求演变

随着云计算的普及和人工智能技术的进步,大数据开发者的技能需求也在快速变化。初期,他们可能需要掌握SQL和基本的数据库管理技能。现在,他们需要熟悉Hadoop、Spark等大数据处理工具,同时对机器学习和数据挖掘有一定的理解和实践经验。

当前,一个全面的大数据开发者技能集应该包括:

- 编程语言:Java、Python、Scala

- 大数据框架:Hadoop、Spark、Flink

- 数据库技术:SQL、NoSQL(如MongoDB、Cassandra)

- 数据仓库工具:Hive、Presto

- 流处理技术:Kafka、Storm

- 机器学习库:TensorFlow、PyTorch、Scikit-learn

- 数据可视化:Tableau、D3.js

- 云计算平台:AWS、Azure、Google Cloud

- 容器化和编排:Docker、Kubernetes

- 版本控制和协作工具:Git、JIRA

未来,随着边缘计算和5G技术的发展,大数据开发者可能还需要掌握实时数据处理和边缘智能相关的技能。

3. 核心技术深入解析

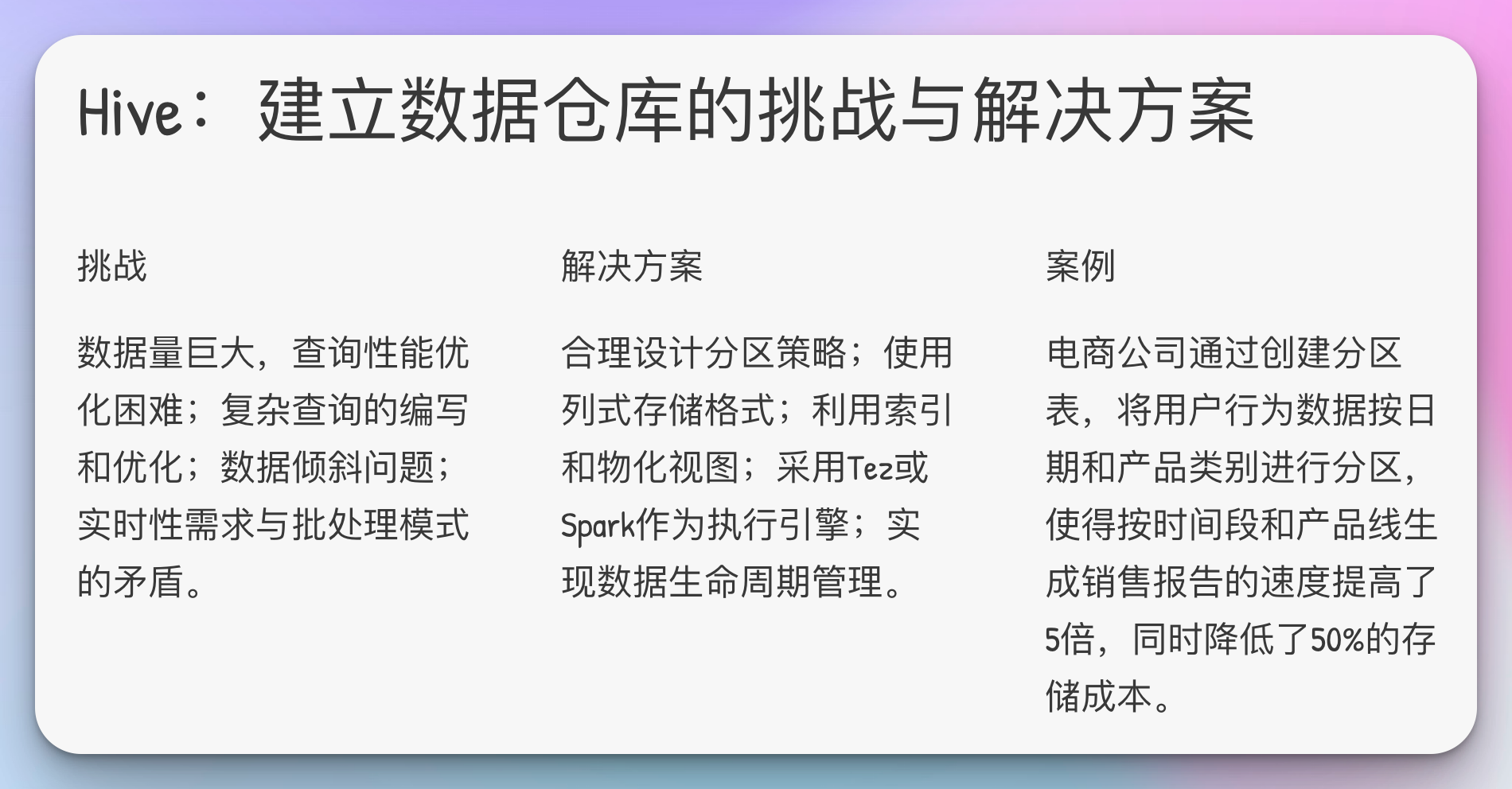

3.1 Hive:建立数据仓库的挑战与解决方案

Hive允许开发者以SQL-like语言(HQL)操作大数据集,它将这些操作转化为MapReduce任务。通过Hive,开发者能够高效地进行数据汇总、查询和分析。

挑战:

- 数据量巨大,查询性能优化困难

- 复杂查询的编写和优化

- 数据倾斜问题

- 实时性需求与批处理模式的矛盾

解决方案:

- 合理设计分区策略,提高查询效率

- 使用列式存储格式(如ORC、Parquet),减少I/O

- 利用索引和物化视图加速查询

- 采用Tez或Spark作为执行引擎,提升性能

- 实现数据生命周期管理,控制存储成本

案例:

一家电商公司使用Hive管理其庞大的用户数据。通过创建分区表,公司能够更快地查询特定日期范围内的数据,大幅提升了报告生成的效率。具体而言,他们将用户行为数据按日期和产品类别进行分区,使得按时间段和产品线生成销售报告的速度提高了5倍,同时降低了50%的存储成本。

-- 使用分区表提高查询效率

CREATE TABLE user_logs (

user_id STRING,

action STRING,

timestamp TIMESTAMP

)

PARTITIONED BY (date STRING)

STORED AS ORC;

-- 插入数据时指定分区

INSERT INTO TABLE user_logs PARTITION (date='2024-07-13')

SELECT user_id, action, timestamp

FROM raw_logs

WHERE TO_DATE(timestamp) = '2024-07-13';

-- 查询特定日期范围的数据

SELECT user_id, COUNT(*) as action_count

FROM user_logs

WHERE date BETWEEN '2024-07-01' AND '2024-07-31'

GROUP BY user_id;3.2 Spark:实时数据处理的案例与优化

Spark的实时处理能力使它成为大数据时代的宠儿。它可以快速处理流数据,支持复杂的数据管道操作。

优化策略:

- 合理设置分区数量,避免数据倾斜

- 利用缓存机制(cache/persist)减少重复计算

- 选择适当的序列化方式(如Kryo)提高性能

- 调整执行器(executor)配置,优化资源利用

- 使用广播变量减少数据传输

案例:

金融服务公司使用Spark Streaming来监控欺诈交易。系统能够实时分析交易模式,并快速识别潜在的欺诈行为,极大地降低了损失。该系统每秒处理超过10万笔交易,通过机器学习模型实时评估风险分数。通过优化Spark配置和算法,他们将欺诈检测的延迟从分钟级降低到了秒级,成功率提高了30%,每年为公司节省数百万美元的潜在损失。

from pyspark.sql import SparkSession

from pyspark.sql.functions import *

from pyspark.sql.types import *

# 创建 SparkSession

spark = SparkSession.builder \

.appName("RealTimeTransactionProcessing") \

.getOrCreate()

# 定义schema

schema = StructType([

StructField("transaction_id", StringType()),

StructField("amount", DoubleType()),

StructField("timestamp", TimestampType())

])

# 从Kafka读取流数据

transactions = spark \

.readStream \

.format("kafka") \

.option("kafka.bootstrap.servers", "localhost:9092") \

.option("subscribe", "transactions") \

.load() \

.select(from_json(col("value").cast("string"), schema).alias("data")) \

.select("data.*")

# 计算5分钟滑动窗口内的交易总额

windowed_sum = transactions \

.withWatermark("timestamp", "10 minutes") \

.groupBy(

window("timestamp", "5 minutes", "1 minute"),

"transaction_id"

) \

.agg(sum("amount").alias("total_amount"))

# 将结果写入控制台(实际应用中可能写入数据库或消息队列)

query = windowed_sum \

.writeStream \

.outputMode("complete") \

.format("console") \

.start()

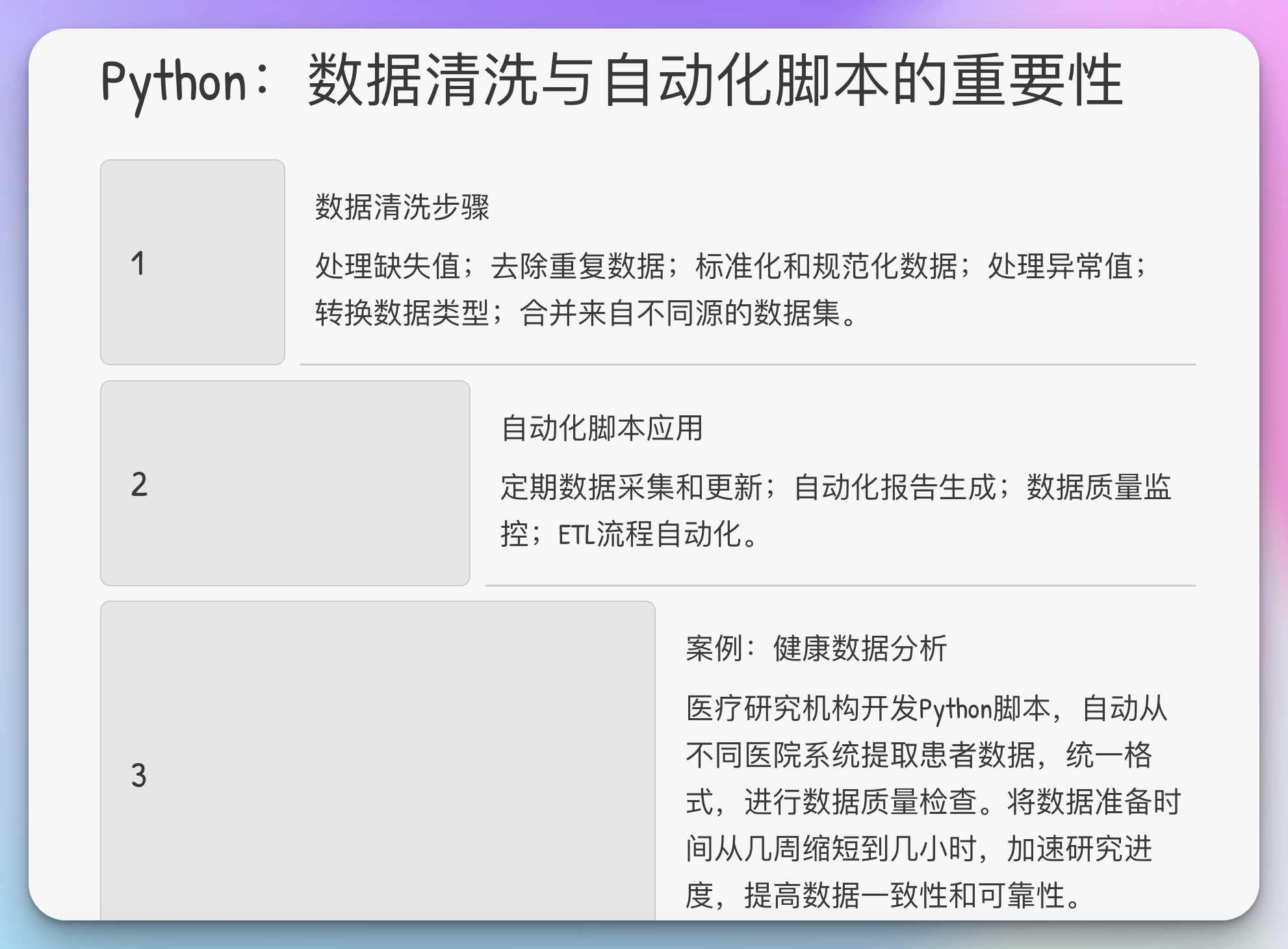

query.awaitTermination()3.3 Python:数据清洗与自动化脚本的重要性

Python在数据科学中的应用非常广泛,特别是在数据清洗和预处理阶段。Pandas库提供了强大的数据结构和操作工具,使得数据处理变得简单高效。

数据清洗的关键步骤:

- 处理缺失值:填充或删除

- 去除重复数据

- 标准化和规范化数据

- 处理异常值

- 转换数据类型

- 合并来自不同源的数据集

自动化脚本的应用:

- 定期数据采集和更新

- 自动化报告生成

- 数据质量监控

- ETL(提取、转换、加载)流程自动化

案例:

健康数据分析中,使用Python的Pandas库来清洗和格式化来自多个源的患者数据。统一的数据格式使得后续的分析更加准确和高效。具体而言,一家医疗研究机构开发了一个Python脚本,自动从不同医院的系统中提取患者数据,统一格式,并进行数据质量检查。这个过程将数据准备时间从原来的几周缩短到了几小时,大大加速了研究进度,并提高了数据的一致性和可靠性。

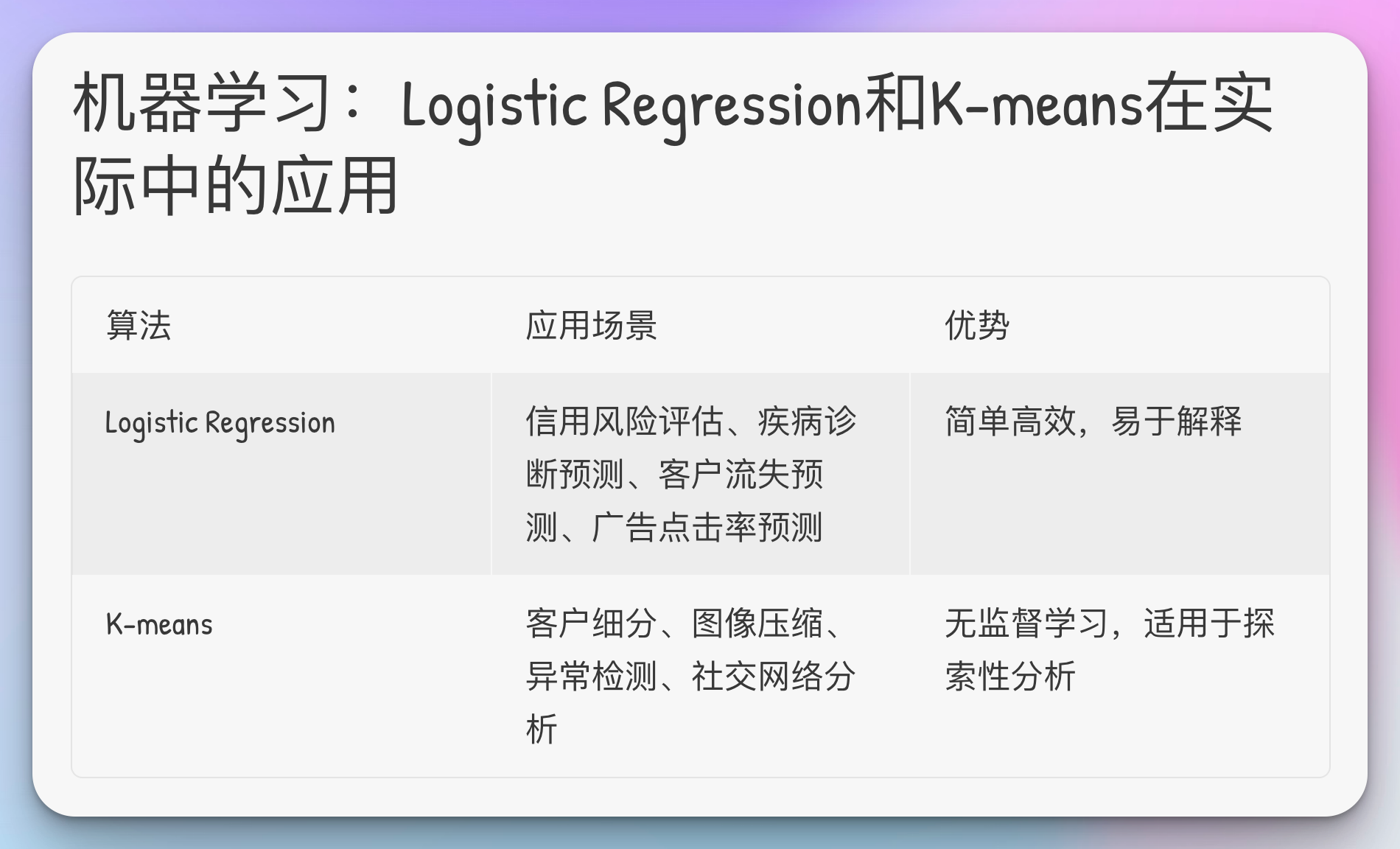

3.4 机器学习:Logistic Regression和K-means在实际中的应用

这两种算法在商业分析和预测模型中非常有用。Logistic Regression常用于预测二分类结果,而K-means用于市场细分和聚类分析。

Logistic Regression应用:

- 信用风险评估

- 疾病诊断预测

- 客户流失预测

- 广告点击率预测

K-means应用:

- 客户细分

- 图像压缩

- 异常检测

- 社交网络分析

案例:

一家零售公司使用K-means算法对客户进行细分,根据购买行为将客户分为不同的群组,从而为每个群组定制营销策略。通过分析客户的购买频率、平均订单价值和最近一次购买时间等特征,该公司成功将客户划分为高价值忠诚客户、潜在高增长客户、低频率购买者等几个群组。针对性的营销策略使得客户转化率提高了15%,平均客户终身价值增加了20%。

import numpy as np

from sklearn.linear_model import LogisticRegression

from sklearn.cluster import KMeans

from sklearn.preprocessing import StandardScaler

from sklearn.model_selection import train_test_split

from sklearn.metrics import accuracy_score, silhouette_score

# Logistic Regression 示例 (二分类问题,如客户流失预测)

X = np.array([[0, "No", 0.1], [2, "Yes", 0.2], [4, "No", 0.3], [6, "Yes", 0.4], [8, "No", 0.5]])

y = np.array([0, 0, 1, 1, 1])

# 特征工程

X_numeric = X[:, [0, 2]].astype(float)

X_categorical = (X[:, 1] == "Yes").astype(int).reshape(-1, 1)

X_processed = np.hstack((X_numeric, X_categorical))

# 划分训练集和测试集

X_train, X_test, y_train, y_test = train_test_split(X_processed, y, test_size=0.2, random_state=42)

# 标准化特征

scaler = StandardScaler()

X_train_scaled = scaler.fit_transform(X_train)

X_test_scaled = scaler.transform(X_test)

# 训练Logistic Regression模型

lr_model = LogisticRegression()

lr_model.fit(X_train_scaled, y_train)

# 预测并评估

y_pred = lr_model.predict(X_test_scaled)

accuracy = accuracy_score(y_test, y_pred)

print(f"Logistic Regression Accuracy: {accuracy}")

# K-means 示例 (客户细分)

# 假设X是客户特征数据

X = np.array([[1, 2], [1.5, 1.8], [5, 8], [8, 8], [1, 0.6], [9, 11]])

# 标准化特征

scaler = StandardScaler()

X_scaled = scaler.fit_transform(X)

# 使用肘部法则确定最佳簇数

inertias = []

for k in range(1, 10):

kmeans = KMeans(n_clusters=k, random_state=42)

kmeans.fit(X_scaled)

inertias.append(kmeans.inertia_)

# 选择最佳簇数(这里假设我们选择了3个簇)

kmeans = KMeans(n_clusters=3, random_state=42)

cluster_labels = kmeans.fit_predict(X_scaled)

# 评估聚类效果

silhouette_avg = silhouette_score(X_scaled, cluster_labels)

print(f"Silhouette Score: {silhouette_avg}")

# 输出每个样本的簇标签

print("Cluster labels:", cluster_labels)4. 实际案例研究

4.1 电商数据分析

问题:

一家大型电商平台面临用户增长放缓、转化率下降的问题,需要优化其推荐系统以提高用户体验和销售额。

解决方案设计:

- 数据收集:整合用户浏览历史、购买记录、搜索行为等多维度数据

- 数据处理:使用Spark进行大规模数据清洗和特征工程

- 模型构建:采用协同过滤和深度学习相结合的推荐算法

- 实时推荐:利用Kafka和Spark Streaming实现实时个性化推荐

- A/B测试:设计对照实验,评估新推荐系统的效果

使用的技术:

- 数据存储:Hadoop HDFS, HBase

- 数据处理:Spark, Hive

- 机器学习:TensorFlow, Spark MLlib

- 实时计算:Kafka, Spark Streaming

- 可视化:Tableau

成果:

- 技术层面:推荐响应时间从秒级降至毫秒级,系统可扩展性提高10倍

- 商业层面:用户点击率提升25%,转化率提高15%,总体销售额增长20%

from pyspark.sql import SparkSession

from pyspark.ml.recommendation import ALS

from pyspark.ml.evaluation import RegressionEvaluator

from pyspark.ml.tuning import ParamGridBuilder, CrossValidator

# 创建SparkSession

spark = SparkSession.builder.appName("RecommendationSystem").getOrCreate()

# 加载数据

ratings = spark.read.csv("user_product_ratings.csv", header=True, inferSchema=True)

# 将数据集分割成训练集和测试集

(training, test) = ratings.randomSplit([0.8, 0.2])

# 初始化ALS推荐器

als = ALS(userCol="user_id", itemCol="product_id", ratingCol="rating",

coldStartStrategy="drop", nonnegative=True)

# 构建参数网格

param_grid = ParamGridBuilder() \

.addGrid(als.rank, [10, 50, 100]) \

.addGrid(als.maxIter, [5, 10]) \

.addGrid(als.regParam, [0.01, 0.1]) \

.build()

# 定义评估器

evaluator = RegressionEvaluator(metricName="rmse", labelCol="rating", predictionCol="prediction")

# 使用CrossValidator进行超参数调优

cv = CrossValidator(estimator=als, estimatorParamMaps=param_grid, evaluator=evaluator, numFolds=3)

# 训练模型

model = cv.fit(training)

# 在测试集上进行预测

predictions = model.transform(test)

# 评估模型

rmse = evaluator.evaluate(predictions)

print(f"Root-mean-square error = {rmse}")

# 为所有用户生成Top-N推荐

user_recs = model.bestModel.recommendForAllUsers(10)

# 显示推荐结果

user_recs.show(5)4.2 金融风控模型建设

问题:

某银行需要构建一个实时风控系统,以快速识别和预防潜在的欺诈交易,同时减少误判对正常用户的影响。

解决方案设计:

- 数据集成:整合交易数据、客户信息、外部黑名单等多源数据

- 特征工程:设计时间序列特征,地理位置特征,行为模式特征等

- 模型训练:使用Logistic Regression作为基础模型,结合梯度提升树(如XGBoost)提高准确性

- 实时评分:开发基于Flink的实时评分引擎,对每笔交易进行风险评估

- 规则引擎:结合专家规则和机器学习模型,实现动态阈值调整

使用的技术:

- 数据处理:Spark, Flink

- 机器学习:Scikit-learn, XGBoost

- 实时计算:Flink, Kafka

- 存储:Elasticsearch

- 监控:Prometheus, Grafana

成果:

- 技术层面:系统可处理峰值10,000 TPS,平均延迟<100ms

- 商业层面:欺诈检测准确率提高30%,误报率下降50%,每年为银行节省约5000万美元损失

4.3 健康医疗数据处理

问题:

一家医疗研究机构希望通过分析大规模的电子健康记录(EHR),开发一个可以预测患者未来五年内患2型糖尿病风险的模型。

解决方案设计:

- 数据收集与整合:从多家医院和诊所收集匿名化的患者数据

- 数据清洗:使用Python进行数据清洗,处理缺失值和异常值

- 特征工程:提取关键健康指标,如BMI、血压、血糖水平等

- 模型开发:使用随机森林和深度学习模型进行风险预测

- 模型解释:使用SHAP (SHapley Additive exPlanations) 值解释模型预测

- 部署与应用:开发Web应用,允许医生输入患者数据获取风险预测

使用的技术:

- 数据处理:Python (Pandas, NumPy)

- 机器学习:Scikit-learn, TensorFlow

- 大数据处理:Spark

- 数据可视化:Matplotlib, Seaborn

- Web应用:Flask, Docker

成果:

- 技术层面:模型在测试集上达到85%的准确率,优于现有的临床风险评分

- 医疗影响:帮助医生提前识别高风险患者,制定预防措施,预计可减少20%的2型糖尿病新发病例

通过这些深入的案例研究,我们可以看到大数据技术在不同领域的实际应用及其巨大潜力。大数据开发者在这个过程中扮演着关键角色,他们不仅需要精通各种技术工具,还要具备跨领域合作和问题解决的能力,以应对复杂的实际挑战。